企業日益頻繁的使用生成式 AI(Generative AI)和大型語言模型(LLMs)來優化業務流程與改善產品和服務,根據近期的 Gartner 研究報告指出,2027 年全球在 AI 軟體的支出預計將成長到 2,980 億美元,年均複合成長率(CAGR)達 19.1%,有些人甚至認為這只是保守估計。

從 Orca 雲端安全平台掃描的資產中,超過 37% 的組織已採用至少一項 AI 服務,其中使用最多的是 Amazon SageMaker 和 Bedrock(68%),其次是 Azure OpenAI(50%),而排名第三的則是 Vertex AI (21%) 。

儘管 AI 帶來了龐大的商業利益和更完善的產品與服務,但仍存在一些不能忽視的問題 — 安全性。在 2024 Orca 雲端安全狀況報告中,我們發現 82% 的 Amazon SageMaker 使用者曾暴露 Jupyter Notebook,讓這些環境成為可公開存取的狀態。而 AI 模型因為訓練資料(Training Data)常包含機敏資料和智慧財產權,使這些雲端資源的潛在風險比其他資源更高,因而衍生出新的資安需求:AI 安全(AI Security)。

雖然 SageMaker Notebook 環境暴露是個嚴重問題,但基於共享責任模式(Shared Responsibility model),這仍屬於使用者的責任。因此,企業應遵循最佳實踐並使用合適的 AI Security 工具,以便輕鬆識別、修復風險,確保 AI 人工智慧和 ML 機器學習工作負載(Workloads)的安全部署。

Orca 正式宣布其雲端安全平台導入完整的端到端 AI 安全態勢管理(AI-SPM)功能,因此 Orca 的客戶能不受限且安全地使用 AI 服務。Orca 全方位的 CNAPP 雲端安全平台提供 AI Security,讓企業不必額外導入其他 AI Security 解決方案,並無縫整合到現有的工作流程中,減少 IT 工作負擔。

為什麼 Orca 要導入 AI-SPM?

許多 AI 模型和大型語言模型(LLMs)面臨的資安風險與其他雲端資產相似,包括可視性不足、不小心開放存取、未加密的機敏資料、影子資料(Shadow Data)和未受保護的金鑰。藉由 Orca 專利的無代理 SideScanning 技術,將雲端安全擴展至 AI Security,提供與其他雲端資產相同的風險洞察和分析數據。此外,Orca 也運用其現有技術來應對 AI Security 特有的使用場景,例如偵測訓練資料(Training Data)中的機敏資料,以免不小心遭 AI 模型和大型語言模型(LLMs)外洩。

由於 Orca 雲端安全平台不使用 agent 代理程式檢查雲端資源,因此能提供連續、100%的覆蓋,一旦部署新的 AI 資源,平台就會立即掃描,並對偵測到的風險發出警報。Orca 不僅涵蓋 AI 人工智慧模型,還包括用於訓練或規劃人工智慧的所有相關套件。

透過整合 AI Security 功能,企業無需採購、部署或學習如何使用單獨的解決方案,只要利用 Orca 雲端安全平台即可作為統一平台來滿足所有雲端安全需求。

Orca 的 AI Security 有哪些功能?

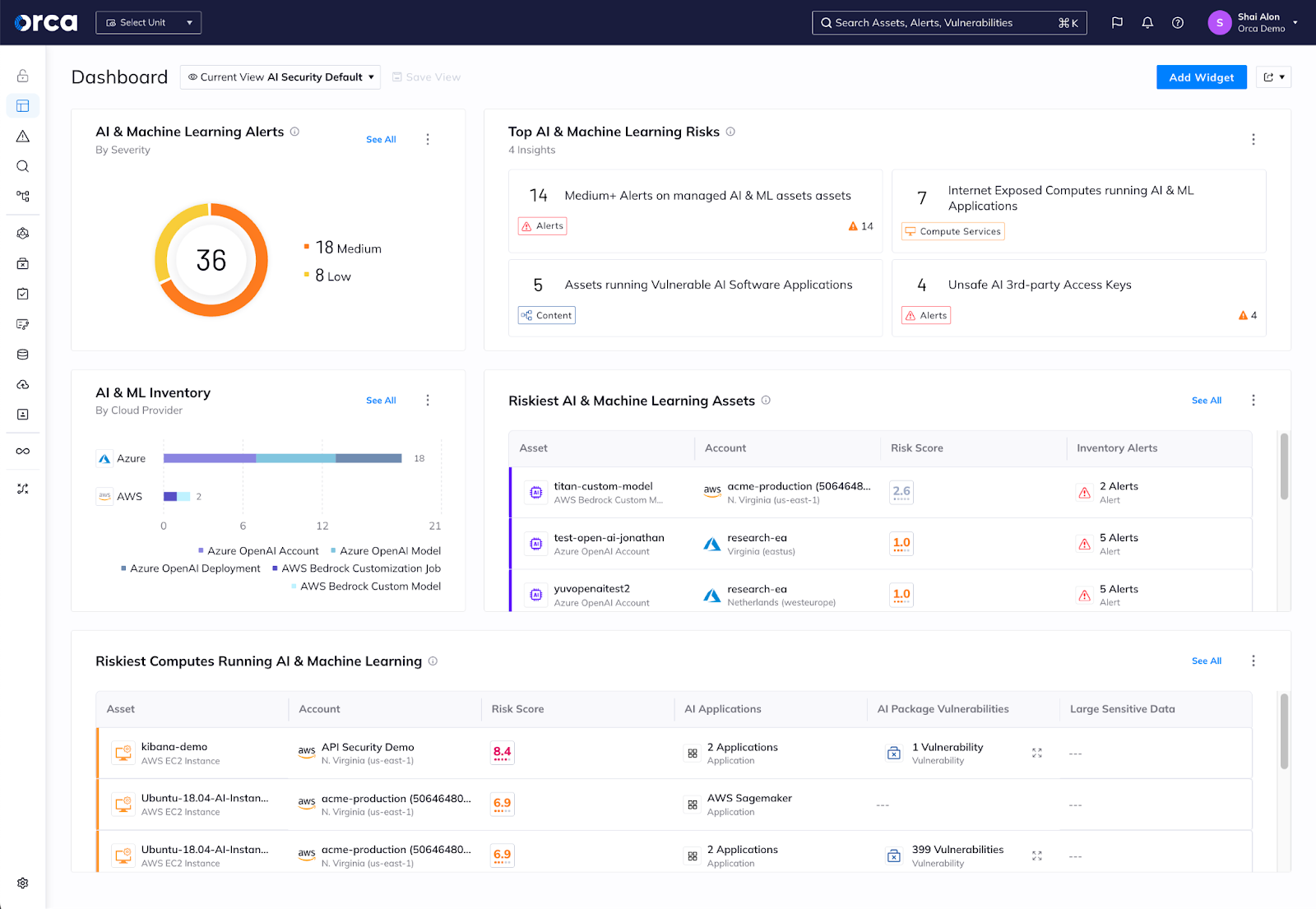

Orca 提供全新的 AI Security 儀表板,可全面檢視雲端環境中部署了哪些 AI 模型、包含哪些資料、是否存在風險。Orca 涵蓋從訓練、校調、正式環境部署到規劃的端到端風險。Orca 連接各個層面中的 AI 資料和流程,包括 託管的雲端 AI 服務、開發人員使用的非託管 AI 模型和軟體包,甚至可以對程式碼庫(Codebase)中 AI 服務外洩的 secret token 進行左移安全檢測。

結合這些洞察,資安團隊可以保護 AI 專案免於未經授權的存取和資料外洩風險。以下我們將介紹 Orca AI Security 的各項功能,並說明企業可能面臨的 AI 挑戰以及 Orca 雲端安全平台如何解決這些問題。

#1. AI/機器學習 BOM 表和 Inventory 盤點

挑戰:與其他雲端資產一樣,影子 AI 和大型語言模型(LLMs)是主要問題。開發人員積極探索生成式 AI 帶來的所有機會,因此在將生成式 AI 服務整合到流程中之前,他們不見得會等待 IT 部門核准,因為資安不是他們首要考慮的因素。這使得資安團隊對開發環境中部署了哪些 AI 專案、是否包含機敏資料以及是否安全均一無所知。

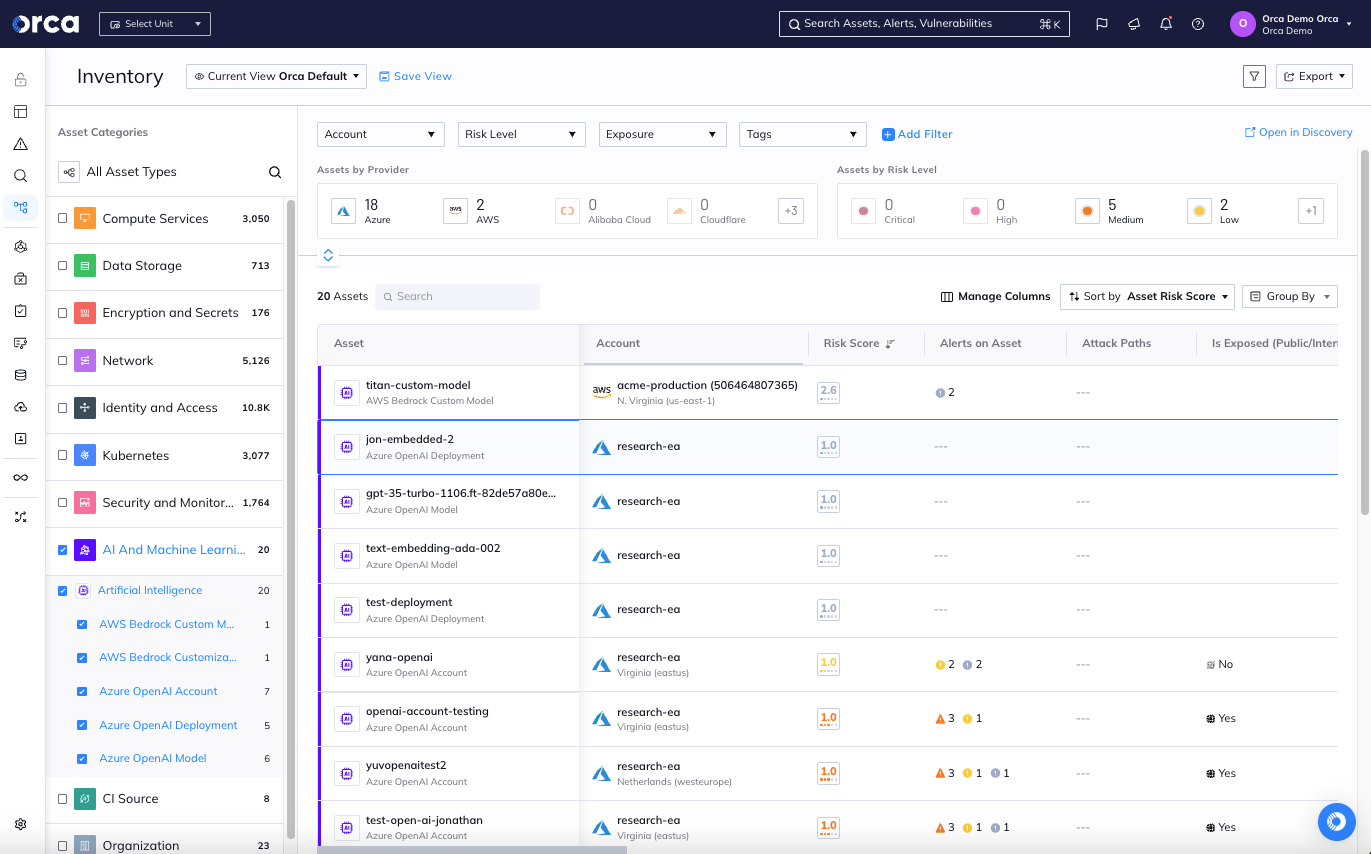

Orca 解決方案:Orca 掃描整個雲端環境並偵測所有部署的 AI 模型,提供完整的 inventory 盤點和 BOM 表。Orca 能偵測 Azure OpenAI、Amazon Bedrock、Google Vertex AI、AWS Sagemaker 等環境以及 50 種以上常見 AI 軟體 package 的 AI 專案,如 Pytorch、TensorFlow、OpenAI、Hugging Face、scikit-learn 等。

Orca 平台顯示所有已部署 AI 模型的 inventory 及 BOM 表

#2. 在 AI 專案設為可公開存取時發出告警

挑戰:用於訓練 AI 模型的資料通常包含重要機敏資料,如果這些資訊外洩,可能會讓企業產生巨大損失,因此確保 AI 模型不會公開曝光至關重要。然而,錯誤配置的情況時常發生,尤其是影子 AI(Shadow AI)。由於安全性並非開發人員的首要考量,使得資安團隊難以確保所有 AI 模型的隱私保護。

Orca 解決方案:由於 Orca 可以深入了解 AI 模型設定和存取狀況,只要允許公開存取,Orca 就會發出告警,因此資安團隊可以快速修復問題,防止任何資料外洩。

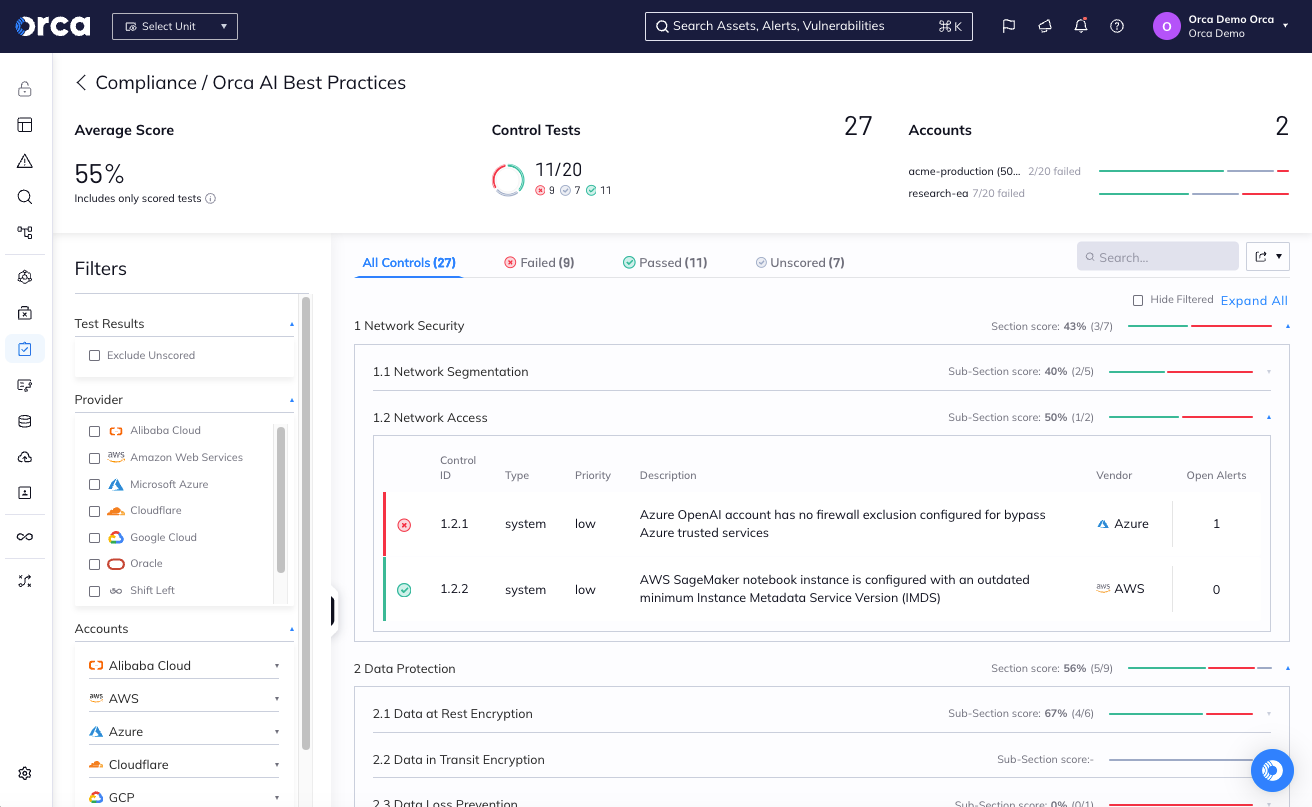

Orca AI Security 的最佳實踐合規功能具備 AI 安全態勢管理(AI-SPM)

#3. 偵測 AI 專案中的機敏資料

挑戰:AI 模型使用大量資料進行訓練,可能無意間夾帶機敏資料,而開發人員和資安團隊可能甚至沒有意識到這些資料的存在,例如個人身份識別資訊(PII)和存取金鑰。大型語言模型(LLMs)和生成式 AI 模型可能因此「洩露」這些機敏資料,進而被惡意人士使用。如果開發人員根本不知道訓練資料包含機敏資訊,他們就更不會優先考慮資源的安全性。

Orca 解決方案:透過 Orca 的資料安全狀態管理(DSPM)功能,Orca 將掃描並分類儲存在 AI 專案中的所有資料,並在找到電子郵件、電話號碼、個人身份識別資訊(PII)、個人健康資訊(PHI)等機敏資料時發出告警。藉由通知資安團隊機敏資料的所在位置,便可確保這些資產受到最高層級的安全保護。

Orca 在 AI Security 儀表板中顯示的相關安全資訊

#4. 確保靜態資料加密

挑戰:雖然企業可採取最佳措施來保護 AI 模型中的資料,但這些機敏資料仍可能遭洩漏。確保資料即使被惡意人士存取也毫無用處,最直接的方法就是對其進行加密。然而,和其他資安控管措施一樣,加密並非開發人員在執行創新 AI 專案時必須考慮的問題。

Orca 解決方案:Orca 在背景中自動掃描 AI 資料並確保所有資料都經過加密,大幅降低可能的風險與不良後果。

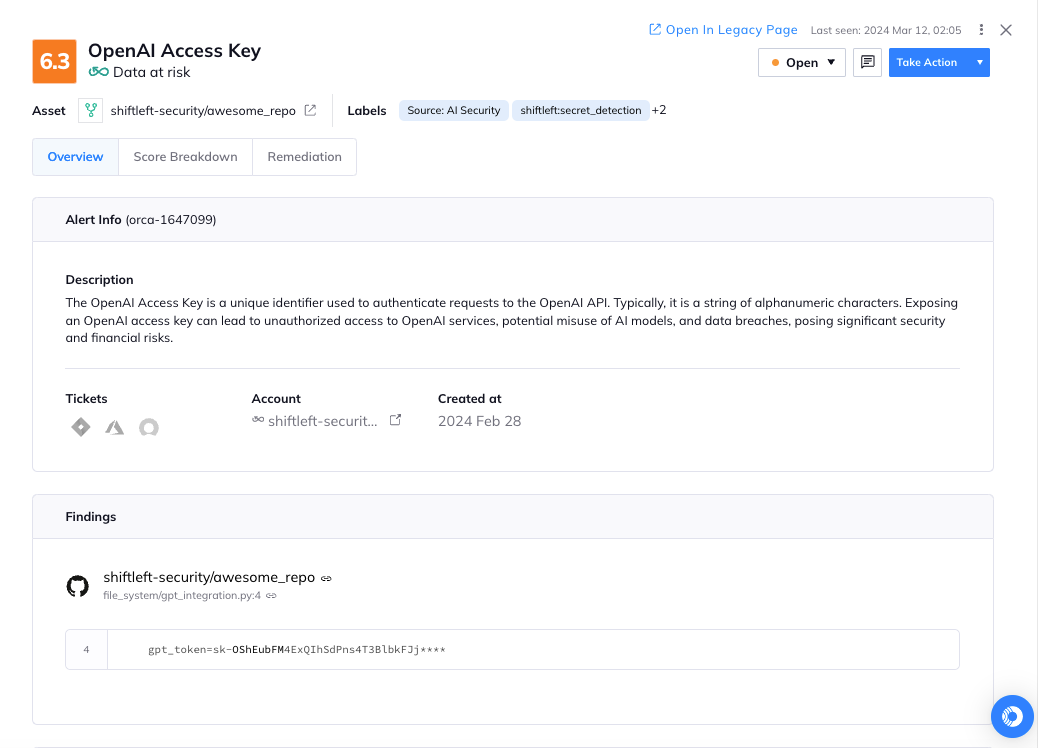

#5. 偵測不安全的第三方 AI 存取金鑰

挑戰:開發人員常將 AI 存取金鑰留在程式碼中,任何取得這些金鑰的人都可以存取 AI 模型並進行 API 請求,這讓惡意人士可以消耗相關資源、存取訓練資料,甚至暗中洩漏資料。此外,存取權限甚至可被用來竄改 AI 模型,產生不適當或有損商譽的內容。

Orca 解決方案:Orca 透過程式碼儲存庫掃描功能(code repository scanning)來檢測 AI 金鑰和 token 是否留存在程式碼儲存庫中,並發出告警,使資安團隊可以迅速移除這些金鑰並控制風險。

Orca 告警:在程式碼儲存庫中找到了 OpenAI 存取金鑰

Orca 能掃描哪些 AI 服務?

Orca 能掃描部署在 Azure OpenAI、Amazon Bedrock、Google Vertex AI、AWS Sagemaker 等環境,以及使用 50 種以上常用 AI 軟體 package 的 AI 模型(如 Pytorch、TensorFlow、OpenAI、Hugging Face、scikit-learn 等)。

資料來源:Orca Security

關於 Orca 雲端安全平台

Orca 可識別、優先排序並修復跨 AWS、Azure、GCP、Oracle Cloud、阿里雲和 Kubernetes 等環境的雲端資產風險和合規問題。Orca 單一整合的全方位雲端安全平台,運用專利的 SideScanning 技術,為用戶檢測漏洞、錯誤配置、橫向移動、API 風險、機敏資料風險、異常事件和行為、權限過高的身份等資安問題。